Pontos-Chave

- RAG (Geração Aumentada por Recuperação) combina encontrar informações relevantes com gerar respostas—é como assistentes de IA respondem perguntas a partir de seus documentos específicos.

- Diferentemente do ChatGPT sozinho, sistemas alimentados por RAG são fundamentados em seu conteúdo, reduzindo alucinações e permitindo respostas precisas sobre sua organização.

- Os componentes-chave são embeddings (compreensão de significado), bancos de dados vetoriais (encontrar conteúdo similar) e LLMs (gerar respostas a partir do contexto).

- A qualidade do RAG depende da qualidade da recuperação—a IA só pode responder bem se encontrar o conteúdo certo primeiro.

Quando você faz uma pergunta ao ChatGPT, ele responde a partir do que aprendeu durante o treinamento—textos da internet de anos atrás. Ele não conhece as políticas da sua empresa, sua documentação de produto ou o anúncio da semana passada.

Isso é suficiente para conhecimento geral. É inútil para conhecimento organizacional.

RAG—Geração Aumentada por Recuperação—resolve isso. É a tecnologia que alimenta assistentes de conhecimento de IA, permitindo que a IA responda perguntas a partir do seu conteúdo específico em vez de apenas conhecimento geral.

Este artigo explica como o RAG funciona. Você não precisa ser técnico para acompanhar—vamos cobrir os conceitos em termos práticos e depois nos aprofundar para aqueles que querem mais detalhes.

O Problema que o RAG Resolve

Grandes modelos de linguagem (LLMs) como o GPT-4 ou Claude são treinados em quantidades massivas de texto. Eles são notavelmente bons em entender e gerar linguagem humana. Mas têm uma limitação fundamental: eles só sabem o que foi usado no treinamento.

Sua política de férias? Não está nos dados de treinamento. Suas especificações de produto? Não estão lá. Seus procedimentos internos? Definitivamente não.

Você tem duas opções:

Opção 1: Fine-tuning. Treinar o modelo com seu conteúdo para que ele "aprenda" suas informações. Isso é caro, lento e problemático para conteúdo que muda. Toda vez que você atualiza uma política, precisaria retreinar o modelo.

Opção 2: Geração Aumentada por Recuperação. Em vez de treinar o modelo com seu conteúdo, você fornece seu conteúdo no momento da consulta. Quando alguém faz uma pergunta, você encontra os documentos relevantes e os entrega à IA junto com a pergunta. A IA gera uma resposta baseada no que você acabou de fornecer.

RAG é a Opção 2. É mais rápido, mais barato e funciona com conteúdo que muda.

Analogia: Fine-tuning é como memorizar um livro-texto. RAG é como fazer uma prova de consulta. O modelo não precisa "saber" seu conteúdo—só precisa ser capaz de lê-lo quando uma pergunta é feita.

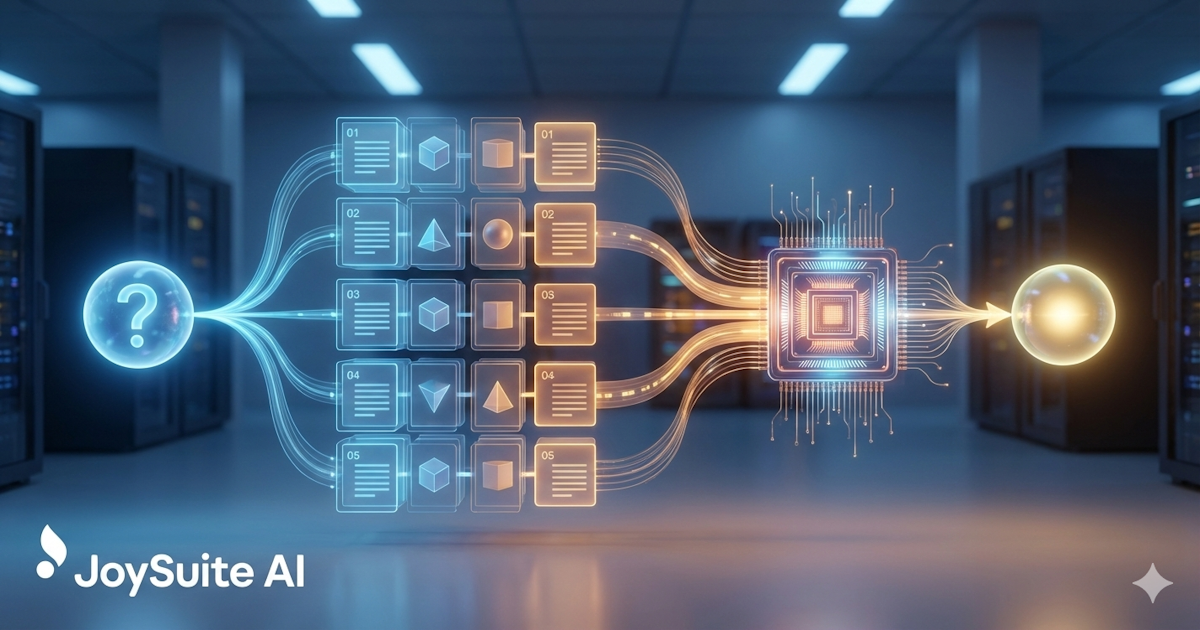

Como o RAG Funciona: A Versão Simples

Aqui está o processo RAG em termos simples:

- Você armazena seus documentos. Suas políticas, procedimentos, documentação—tudo sobre o que você quer que a IA responda perguntas—são processados e armazenados em um banco de dados especial.

- Alguém faz uma pergunta. "Qual é nossa política de licença parental?"

- O sistema encontra conteúdo relevante. Ele busca em seus documentos armazenados as seções com maior probabilidade de conter a resposta.

- A IA lê e responde. O conteúdo relevante é fornecido à IA junto com a pergunta. A IA o lê e gera uma resposta.

- Você recebe uma resposta com fontes. A resposta inclui de onde veio a informação, para que você possa verificar.

A percepção-chave: a IA não está tentando lembrar suas políticas do treinamento. Ela está lendo-as agora, em resposta à sua pergunta.

Os Componentes Técnicos

Para aqueles que querem entender o que está acontecendo por trás dos panos, o RAG envolve vários componentes técnicos trabalhando juntos.

Embeddings: Compreendendo o Significado

Computadores não entendem linguagem naturalmente. A palavra "férias" e "licença" significam coisas similares para humanos, mas para um computador, são apenas diferentes sequências de caracteres.

Embeddings resolvem isso convertendo texto em números que capturam significado. Especificamente, embeddings convertem texto em listas de números (vetores) onde significados similares produzem números similares.

"Qual é nossa política de licença?" e "Quanto de férias eu tenho?" teriam embeddings similares, mesmo que compartilhem poucas palavras. É assim que o sistema entende que estão perguntando a mesma coisa.

Exemplo: "Rei" e "Rainha" teriam embeddings similares—ambos são realeza. "Rei" e "Teclado" teriam embeddings muito diferentes apesar de ambos começarem com a mesma letra.

Bancos de Dados Vetoriais: Encontrando Conteúdo Similar

Uma vez que você converteu seus documentos em embeddings, precisa armazená-los e buscá-los eficientemente. É isso que os bancos de dados vetoriais fazem.

Quando alguém faz uma pergunta, você:

- Converte a pergunta em um embedding

- Busca no banco de dados vetorial por embeddings de documentos que são similares

- Retorna os pedaços de documento mais similares

Isso é "busca semântica"—encontrar conteúdo por significado em vez de apenas correspondência de palavras-chave. É por isso que "Como solicitar folga?" pode encontrar um documento intitulado "Procedimento de Solicitação de Licença."

Chunking: Dividindo Documentos

LLMs só podem processar uma certa quantidade de texto de cada vez (sua "janela de contexto"). Um manual de políticas de 100 páginas não vai caber. Então os documentos são divididos em pedaços menores—talvez 500-1000 palavras cada.

Quando você busca, está encontrando os pedaços mais relevantes, não documentos inteiros. Isso é na verdade uma vantagem: você dá à IA exatamente a seção relevante em vez de fazê-la processar páginas de conteúdo irrelevante.

Como você divide os documentos importa. Muito pequeno, e os pedaços ficam sem contexto. Muito grande, e você dilui informação relevante com texto irrelevante. A arte do chunking é encontrar a granularidade certa para seu conteúdo.

Grandes Modelos de Linguagem: Gerando Respostas

Uma vez que você recuperou o conteúdo relevante, um LLM gera a resposta. O LLM recebe:

- A pergunta do usuário

- O conteúdo recuperado (o "contexto")

- Instruções sobre como responder (o "prompt do sistema")

Um prompt típico pode dizer: "Responda a pergunta do usuário baseado apenas no contexto fornecido. Se o contexto não contiver informação suficiente para responder, diga isso. Cite suas fontes."

O LLM então gera uma resposta baseada nessa combinação—uma resposta em linguagem natural extraída do seu conteúdo específico.

Por que RAG Supera Outras Abordagens

vs. LLMs Simples

Usar um LLM sem RAG significa depender dos dados de treinamento do modelo. Para conhecimento organizacional, isso significa alucinação—o modelo vai inventar respostas plausíveis mas incorretas.

RAG fundamenta o modelo no seu conteúdo real. O risco de alucinação é reduzido (embora não eliminado) porque o modelo tem material de fonte real com que trabalhar.

vs. Fine-tuning

Fine-tuning treina o modelo no seu conteúdo. Isso pode funcionar mas tem desvantagens significativas:

- Caro e demorado

- Precisa ser refeito quando o conteúdo muda

- Não escala bem para grandes coleções de documentos

- Pode degradar o desempenho em outras tarefas

RAG é mais prático para a maioria dos casos de uso de gestão de conhecimento. O conteúdo pode mudar, e o sistema se adapta imediatamente.

vs. Busca Tradicional

Busca tradicional retorna documentos. RAG retorna respostas. A experiência do usuário é dramaticamente melhor—em vez de escanear resultados de busca e ler documentos, os usuários recebem respostas diretas às suas perguntas.

O que Torna o RAG Bom ou Ruim

Nem todas as implementações de RAG são iguais. A qualidade depende de vários fatores:

Qualidade da Recuperação

A IA só pode responder bem se encontrar o conteúdo certo. Recuperação ruim—perdendo documentos relevantes ou incluindo irrelevantes—leva a respostas ruins.

A qualidade da recuperação depende de:

- Qualidade do modelo de embedding

- Estratégia de chunking

- Sofisticação do algoritmo de busca

- Cobertura e organização do conteúdo

O melhor LLM do mundo não pode responder a partir de conteúdo que não foi fornecido. A recuperação é a fundação—se ela é fraca, tudo construído sobre ela sofre.

Qualidade do Conteúdo

RAG só pode responder a partir do que está na sua base de conhecimento. Se suas políticas estão desatualizadas, a IA fornecerá informações desatualizadas—com confiança. Se você tem documentos contraditórios, a IA pode citar o errado.

Este é o requisito frequentemente negligenciado: RAG torna a qualidade do seu conteúdo mais importante, não menos. A IA amplifica o que quer que você tenha—bom ou ruim.

Engenharia de Prompt

Como você instrui o LLM importa. Bons prompts ajudam o modelo a:

- Permanecer fundamentado no contexto fornecido

- Reconhecer quando não tem informação suficiente

- Formatar respostas claramente

- Citar fontes adequadamente

Prompts ruins levam a alucinação, respostas inúteis ou falha em usar o contexto recuperado efetivamente.

Estratégia de Chunking

Como os documentos são divididos em pedaços afeta o que é recuperado e quão útil é. O mesmo documento pode ter desempenho muito diferente dependendo de como é dividido.

RAG na Prática

Veja como uma interação alimentada por RAG realmente se parece:

Usuário pergunta: "Qual é o processo para solicitar uma licença?"

Sistema encontra: Três pedaços relevantes de seus documentos de política de RH e manual do funcionário.

Sistema envia ao LLM: A pergunta mais esses três pedaços mais instruções para responder baseado no conteúdo.

LLM gera: "Para solicitar uma licença, envie uma solicitação através do portal de RH com pelo menos 30 dias de antecedência. Você precisará especificar as datas, motivo da licença e se está solicitando licença remunerada ou não remunerada. Seu gerente e o RH revisarão e responderão dentro de 5 dias úteis. Para licenças médicas, documentação adicional de um profissional de saúde pode ser necessária."

Usuário recebe: A resposta mais citações mostrando de quais documentos a informação veio.

Todo o processo leva segundos. O usuário não precisou buscar em múltiplos documentos ou saber qual terminologia usar.

Limitações do RAG

RAG não é perfeito. Entender suas limitações ajuda a definir expectativas realistas.

O Risco de Alucinação Permanece

RAG reduz alucinação mas não a elimina. O LLM ainda pode interpretar mal o conteúdo, fazer inferências incorretas ou ocasionalmente gerar informações que não estão no contexto.

É por isso que citações importam—usuários podem verificar afirmações contra documentos fonte.

Falhas na Recuperação

Às vezes o conteúdo certo existe mas não é recuperado. A pergunta pode usar terminologia diferente, ou a informação relevante pode estar espalhada por documentos de maneiras que tornam a recuperação difícil.

Limites da Janela de Contexto

LLMs só podem processar uma certa quantidade de texto. Perguntas complexas que requerem sintetizar muitos documentos podem atingir limites de quanto contexto pode ser fornecido.

Lacunas de Conteúdo

RAG não pode responder perguntas sobre coisas que não estão documentadas. Se a informação não está na sua base de conhecimento, a IA não pode encontrá-la.

Importante: Quando a IA não pode responder, você quer que ela diga isso claramente em vez de inventar algo. Boas implementações de RAG são honestas sobre limitações—mas isso requer engenharia de prompt cuidadosa.

O Futuro do RAG

A tecnologia continua evoluindo rapidamente:

Melhores métodos de recuperação. Abordagens híbridas combinando busca semântica e por palavra-chave, modelos de re-ranqueamento e técnicas de múltiplas consultas estão melhorando a qualidade da recuperação.

Janelas de contexto maiores. Modelos estão lidando com mais contexto, permitindo respostas de mais fontes simultaneamente.

Capacidades multimodais. RAG está se expandindo além de texto para incluir imagens, diagramas e outros tipos de conteúdo.

Comportamento agêntico. Sistemas RAG estão começando a tomar ações—não apenas respondendo perguntas mas realizando tarefas baseadas em conhecimento recuperado.

Conclusão

RAG é a tecnologia que torna prática a gestão de conhecimento com IA. Ao combinar recuperação com geração, permite que a IA responda perguntas a partir do seu conteúdo específico—não apenas conhecimento geral.

A percepção-chave: RAG não torna a IA mais inteligente sobre sua organização. Dá à IA acesso ao conhecimento da sua organização no momento em que precisa responder. A IA lê seu conteúdo e gera uma resposta a partir do que lê.

Esta arquitetura simples tem implicações profundas. Conhecimento que estava preso em documentos se torna acessível através de conversa natural. Perguntas que requeriam buscar, ler e sintetizar podem ser respondidas instantaneamente.

Entender RAG ajuda você a avaliar ferramentas de conhecimento de IA, definir expectativas realistas e investir apropriadamente em qualidade de conteúdo—a fundação sobre a qual o RAG é construído.

JoySuite usa arquitetura RAG sofisticada para entregar respostas instantâneas a partir do conhecimento organizacional. Conecte suas fontes de conteúdo, e deixe a IA fazer o trabalho de encontrar e sintetizar informações—para que sua equipe possa focar no trabalho que realmente importa.