Points clés

- Le RAG (Retrieval-Augmented Generation ou génération augmentée par récupération) combine la recherche d'informations pertinentes avec la génération de réponses—c'est ainsi que les assistants IA répondent aux questions à partir de vos documents spécifiques.

- Contrairement à ChatGPT utilisé seul, les systèmes alimentés par RAG sont ancrés dans votre contenu, réduisant les hallucinations et permettant des réponses précises sur votre organisation.

- Les composantes clés sont les embeddings (comprendre le sens), les bases de données vectorielles (trouver du contenu similaire) et les LLM (générer des réponses à partir du contexte).

- La qualité du RAG dépend de la qualité de la récupération—l'IA ne peut bien répondre que si elle trouve d'abord le bon contenu.

Lorsque vous posez une question à ChatGPT, il répond à partir de ce qu'il a appris durant son entraînement—du texte internet datant d'il y a plusieurs années. Il ne connaît pas les politiques de votre entreprise, votre documentation produit ou l'annonce de la semaine dernière.

C'est acceptable pour les connaissances générales. C'est inutile pour les connaissances organisationnelles.

Le RAG—Retrieval-Augmented Generation—résout ce problème. C'est la technologie qui alimente les assistants IA de connaissances, permettant à l'IA de répondre aux questions à partir de votre contenu spécifique plutôt que seulement des connaissances générales.

Cet article explique comment fonctionne le RAG. Vous n'avez pas besoin d'être technique pour suivre—nous couvrirons les concepts en termes pratiques, puis nous approfondirons pour ceux qui veulent plus de détails.

Le problème que résout le RAG

Les grands modèles de langage (LLM) comme GPT-4 ou Claude sont entraînés sur des quantités massives de texte. Ils sont remarquablement bons pour comprendre et générer du langage humain. Mais ils ont une limitation fondamentale : ils ne connaissent que ce sur quoi ils ont été entraînés.

Votre politique de vacances? Pas dans les données d'entraînement. Vos spécifications produit? Pas là non plus. Vos procédures internes? Certainement pas.

Vous avez deux options :

Option 1 : Le fine-tuning. Entraîner le modèle sur votre contenu pour qu'il « apprenne » vos informations. C'est coûteux, lent et problématique pour le contenu qui change. Chaque fois que vous mettez à jour une politique, vous devriez réentraîner le modèle.

Option 2 : La génération augmentée par récupération. Au lieu d'entraîner le modèle sur votre contenu, vous lui donnez votre contenu au moment de la requête. Lorsque quelqu'un pose une question, vous trouvez les documents pertinents et vous les remettez à l'IA avec la question. L'IA génère une réponse basée sur ce que vous venez de lui donner.

Le RAG est l'option 2. C'est plus rapide, moins cher et fonctionne avec du contenu qui change.

Analogie : Le fine-tuning, c'est comme mémoriser un manuel. Le RAG, c'est comme passer un examen à livre ouvert. Le modèle n'a pas besoin de « connaître » votre contenu—il doit juste pouvoir le lire lorsqu'on lui pose une question.

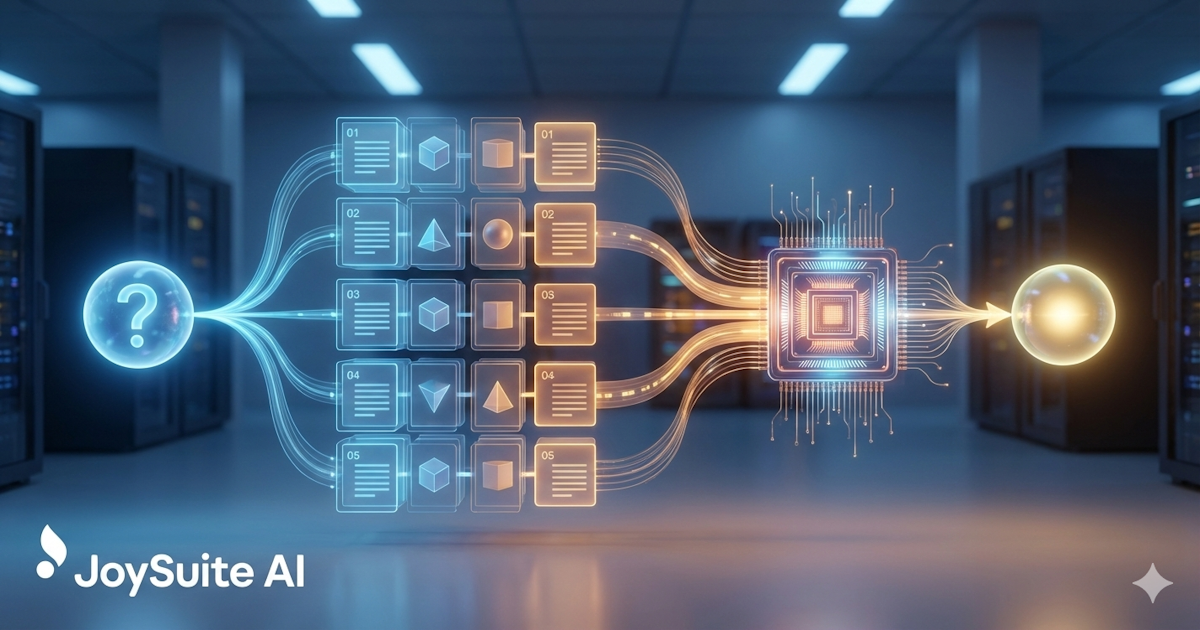

Comment fonctionne le RAG : la version simple

Voici le processus RAG en termes simples :

- Vous stockez vos documents. Vos politiques, procédures, documentation—tout ce sur quoi vous voulez que l'IA réponde—sont traités et stockés dans une base de données spéciale.

- Quelqu'un pose une question. « Quelle est notre politique de congé parental? »

- Le système trouve le contenu pertinent. Il recherche dans vos documents stockés les sections les plus susceptibles de contenir la réponse.

- L'IA lit et répond. Le contenu pertinent est donné à l'IA avec la question. L'IA le lit et génère une réponse.

- Vous obtenez une réponse avec les sources. La réponse inclut la provenance de l'information, pour que vous puissiez vérifier.

L'idée clé : l'IA n'essaie pas de se rappeler de vos politiques à partir de son entraînement. Elle les lit maintenant, en réponse à votre question.

Les composantes techniques

Pour ceux qui veulent comprendre ce qui se passe sous le capot, le RAG implique plusieurs composantes techniques qui travaillent ensemble.

Embeddings : comprendre le sens

Les ordinateurs ne comprennent pas naturellement le langage. Le mot « vacances » et « congé » signifient des choses similaires pour les humains, mais pour un ordinateur, ce sont juste des chaînes de caractères différentes.

Les embeddings résolvent cela en convertissant le texte en nombres qui capturent le sens. Spécifiquement, les embeddings convertissent le texte en listes de nombres (vecteurs) où des sens similaires produisent des nombres similaires.

« Quelle est notre politique de congé? » et « Combien de vacances ai-je? » auraient des embeddings similaires, même s'ils partagent peu de mots. C'est ainsi que le système comprend qu'ils posent la même chose.

Exemple : « Roi » et « Reine » auraient des embeddings similaires—ce sont tous deux de la royauté. « Roi » et « Clavier » auraient des embeddings très différents malgré qu'ils commencent tous deux par une consonne.

Bases de données vectorielles : trouver du contenu similaire

Une fois que vous avez converti vos documents en embeddings, vous devez les stocker et les rechercher efficacement. C'est ce que font les bases de données vectorielles.

Lorsque quelqu'un pose une question, vous :

- Convertissez la question en embedding

- Recherchez dans la base de données vectorielle les embeddings de documents qui sont similaires

- Retournez les fragments de documents les plus similaires

C'est la « recherche sémantique »—trouver du contenu par le sens plutôt que simplement par correspondance de mots-clés. C'est pourquoi « Comment demander un congé? » peut trouver un document intitulé « Procédure de demande de vacances. »

Fragmentation : décomposer les documents

Les LLM ne peuvent traiter qu'une certaine quantité de texte à la fois (leur « fenêtre de contexte »). Un manuel de politiques de 100 pages ne rentrera pas. Donc les documents sont divisés en fragments plus petits—peut-être 500 à 1000 mots chacun.

Lorsque vous recherchez, vous trouvez les fragments les plus pertinents, pas des documents entiers. C'est en fait un avantage : vous donnez à l'IA exactement la section pertinente plutôt que de la faire traiter des pages de contenu non pertinent.

La façon dont vous fragmentez les documents est importante. Trop petits, et les fragments manquent de contexte. Trop grands, et vous diluez l'information pertinente avec du texte non pertinent. L'art de la fragmentation consiste à trouver la bonne granularité pour votre contenu.

Grands modèles de langage : générer des réponses

Une fois que vous avez récupéré le contenu pertinent, un LLM génère la réponse. Le LLM reçoit :

- La question de l'utilisateur

- Le contenu récupéré (le « contexte »)

- Des instructions sur comment répondre (le « prompt système »)

Un prompt typique pourrait dire : « Réponds à la question de l'utilisateur en te basant uniquement sur le contexte fourni. Si le contexte ne contient pas assez d'information pour répondre, dis-le. Cite tes sources. »

Le LLM génère alors une réponse basée sur cette combinaison—une réponse en langage naturel tirée de votre contenu spécifique.

Pourquoi le RAG surpasse les autres approches

vs. LLM de base

Utiliser un LLM sans RAG signifie compter sur les données d'entraînement du modèle. Pour les connaissances organisationnelles, cela signifie l'hallucination—le modèle inventera des réponses plausibles mais incorrectes.

Le RAG ancre le modèle dans votre contenu réel. Le risque d'hallucination est réduit (mais pas éliminé) parce que le modèle a du matériel source réel avec lequel travailler.

vs. Fine-tuning

Le fine-tuning entraîne le modèle sur votre contenu. Cela peut fonctionner mais a des inconvénients importants :

- Coûteux et chronophage

- Doit être refait lorsque le contenu change

- Ne passe pas bien à l'échelle pour de grandes collections de documents

- Peut dégrader la performance sur d'autres tâches

Le RAG est plus pratique pour la plupart des cas d'utilisation de gestion des connaissances. Le contenu peut changer, et le système s'adapte immédiatement.

vs. Recherche traditionnelle

La recherche traditionnelle retourne des documents. Le RAG retourne des réponses. L'expérience utilisateur est considérablement meilleure—au lieu de parcourir les résultats de recherche et lire des documents, les utilisateurs obtiennent des réponses directes à leurs questions.

Ce qui rend le RAG bon ou mauvais

Toutes les implémentations de RAG ne sont pas égales. La qualité dépend de plusieurs facteurs :

Qualité de la récupération

L'IA ne peut bien répondre que si elle trouve le bon contenu. Une mauvaise récupération—manquer des documents pertinents ou inclure des documents non pertinents—conduit à de mauvaises réponses.

La qualité de la récupération dépend de :

- La qualité du modèle d'embedding

- La stratégie de fragmentation

- La sophistication de l'algorithme de recherche

- La couverture et l'organisation du contenu

Le meilleur LLM au monde ne peut pas répondre à partir de contenu qui ne lui a pas été donné. La récupération est la fondation—si elle est faible, tout ce qui est construit dessus en souffre.

Qualité du contenu

Le RAG ne peut répondre qu'à partir de ce qui est dans votre base de connaissances. Si vos politiques sont désuètes, l'IA fournira des informations désuètes—avec confiance. Si vous avez des documents contradictoires, l'IA peut citer le mauvais.

C'est l'exigence souvent négligée : le RAG rend la qualité de votre contenu plus importante, pas moins. L'IA amplifie ce que vous avez—bon ou mauvais.

Ingénierie des prompts

La façon dont vous donnez des instructions au LLM est importante. De bons prompts aident le modèle à :

- Rester ancré dans le contexte fourni

- Reconnaître quand il n'a pas assez d'information

- Formater les réponses clairement

- Citer les sources correctement

De mauvais prompts conduisent à l'hallucination, des réponses peu utiles ou l'échec à utiliser efficacement le contexte récupéré.

Stratégie de fragmentation

La façon dont les documents sont divisés en fragments affecte ce qui est récupéré et son utilité. Le même document peut performer très différemment selon comment il est fragmenté.

Le RAG en pratique

Voici à quoi ressemble une interaction alimentée par RAG :

L'utilisateur demande : « Quel est le processus pour demander un congé? »

Le système trouve : Trois fragments pertinents de vos documents de politiques RH et manuel de l'employé.

Le système envoie au LLM : La question plus ces trois fragments plus des instructions pour répondre basé sur le contenu.

Le LLM génère : « Pour demander un congé, soumettez une demande via le portail RH au moins 30 jours à l'avance. Vous devrez spécifier les dates, la raison du congé et si vous demandez un congé payé ou non payé. Votre gestionnaire et les RH examineront et répondront dans les 5 jours ouvrables. Pour les congés médicaux, de la documentation additionnelle d'un fournisseur de soins de santé peut être requise. »

L'utilisateur reçoit : La réponse plus les citations montrant de quels documents provient l'information.

Le processus entier prend quelques secondes. L'utilisateur n'a pas eu besoin de chercher à travers plusieurs documents ou de savoir quelle terminologie utiliser.

Limitations du RAG

Le RAG n'est pas parfait. Comprendre ses limitations aide à établir des attentes réalistes.

Le risque d'hallucination demeure

Le RAG réduit l'hallucination mais ne l'élimine pas. Le LLM peut encore mal interpréter le contenu, faire des inférences incorrectes ou occasionnellement générer de l'information qui n'est pas dans le contexte.

C'est pourquoi les citations sont importantes—les utilisateurs peuvent vérifier les affirmations contre les documents sources.

Échecs de récupération

Parfois le bon contenu existe mais n'est pas récupéré. La question peut utiliser une terminologie différente, ou l'information pertinente peut être répartie à travers les documents de façons qui rendent la récupération difficile.

Limites de la fenêtre de contexte

Les LLM ne peuvent traiter qu'une certaine quantité de texte. Les questions complexes qui nécessitent de synthétiser plusieurs documents peuvent atteindre des limites sur la quantité de contexte qui peut être fournie.

Lacunes de contenu

Le RAG ne peut pas répondre aux questions sur des choses qui ne sont pas documentées. Si l'information n'est pas dans votre base de connaissances, l'IA ne peut pas la trouver.

Important : Lorsque l'IA ne peut pas répondre, vous voulez qu'elle le dise clairement plutôt que d'inventer quelque chose. Les bonnes implémentations de RAG sont honnêtes sur les limitations—mais cela nécessite une ingénierie de prompts minutieuse.

L'avenir du RAG

La technologie continue d'évoluer rapidement :

Meilleures méthodes de récupération. Des approches hybrides combinant recherche sémantique et par mots-clés, des modèles de reclassement et des techniques multi-requêtes améliorent la qualité de la récupération.

Fenêtres de contexte plus grandes. Les modèles gèrent plus de contexte, permettant des réponses à partir de plus de sources simultanément.

Capacités multimodales. Le RAG s'étend au-delà du texte pour inclure des images, diagrammes et autres types de contenu.

Comportement agentique. Les systèmes RAG commencent à prendre des actions—pas seulement répondre aux questions mais effectuer des tâches basées sur les connaissances récupérées.

Conclusion

Le RAG est la technologie qui rend la gestion des connaissances par IA pratique. En combinant récupération et génération, il permet à l'IA de répondre aux questions à partir de votre contenu spécifique—pas seulement des connaissances générales.

L'idée clé : le RAG ne rend pas l'IA plus intelligente sur votre organisation. Il donne à l'IA accès aux connaissances de votre organisation au moment où elle doit répondre. L'IA lit votre contenu et génère une réponse à partir de ce qu'elle lit.

Cette architecture simple a des implications profondes. Les connaissances qui étaient piégées dans des documents deviennent accessibles par conversation naturelle. Les questions qui nécessitaient de chercher, lire et synthétiser peuvent être répondues instantanément.

Comprendre le RAG vous aide à évaluer les outils IA de connaissances, établir des attentes réalistes et investir de façon appropriée dans la qualité du contenu—la fondation sur laquelle le RAG se construit.

JoySuite utilise une architecture RAG sophistiquée pour livrer des réponses instantanées à partir de vos connaissances organisationnelles. Connectez vos sources de contenu, et laissez l'IA faire le travail de trouver et synthétiser l'information—pour que votre équipe puisse se concentrer sur le travail qui compte.