Puntos clave

- RAG (Generación Aumentada por Recuperación) combina la búsqueda de información relevante con la generación de respuestas: así es como los asistentes de IA responden preguntas sobre tus documentos específicos.

- A diferencia de ChatGPT por sí solo, los sistemas impulsados por RAG se fundamentan en tu contenido, reduciendo las alucinaciones y permitiendo respuestas precisas sobre tu organización.

- Los componentes clave son los embeddings (comprensión del significado), las bases de datos vectoriales (búsqueda de contenido similar) y los LLM (generación de respuestas a partir del contexto).

- La calidad de RAG depende de la calidad de recuperación: la IA solo puede responder bien si primero encuentra el contenido correcto.

Cuando le haces una pregunta a ChatGPT, responde a partir de lo que aprendió durante su entrenamiento: texto de internet de hace años. No conoce las políticas de tu empresa, la documentación de tus productos ni el anuncio de la semana pasada.

Esto está bien para conocimiento general. Es inútil para conocimiento organizacional.

RAG—Generación Aumentada por Recuperación—resuelve esto. Es la tecnología que impulsa los asistentes de conocimiento de IA, permitiendo que la IA responda preguntas a partir de tu contenido específico en lugar de solo conocimiento general.

Este artículo explica cómo funciona RAG. No necesitas ser técnico para seguirlo: cubriremos los conceptos en términos prácticos y luego profundizaremos más para quienes deseen más detalle.

El Problema que RAG Resuelve

Los modelos de lenguaje grandes (LLM) como GPT-4 o Claude se entrenan con cantidades masivas de texto. Son extraordinariamente buenos para comprender y generar lenguaje humano. Pero tienen una limitación fundamental: solo saben lo que se usó para entrenarlos.

¿Tu política de vacaciones? No está en los datos de entrenamiento. ¿Tus especificaciones de producto? Tampoco. ¿Tus procedimientos internos? Definitivamente no.

Tienes dos opciones:

Opción 1: Fine-tuning. Entrenar el modelo con tu contenido para que "aprenda" tu información. Esto es costoso, lento y problemático para contenido que cambia. Cada vez que actualices una política, tendrías que reentrenar el modelo.

Opción 2: Generación Aumentada por Recuperación. En lugar de entrenar el modelo con tu contenido, se lo proporcionas al momento de la consulta. Cuando alguien hace una pregunta, encuentras los documentos relevantes y se los entregas a la IA junto con la pregunta. La IA genera una respuesta basada en lo que acabas de darle.

RAG es la Opción 2. Es más rápida, más económica y funciona con contenido que cambia.

Analogía: El fine-tuning es como memorizar un libro de texto. RAG es como presentar un examen a libro abierto. El modelo no necesita "conocer" tu contenido, solo necesita poder leerlo cuando se le hace una pregunta.

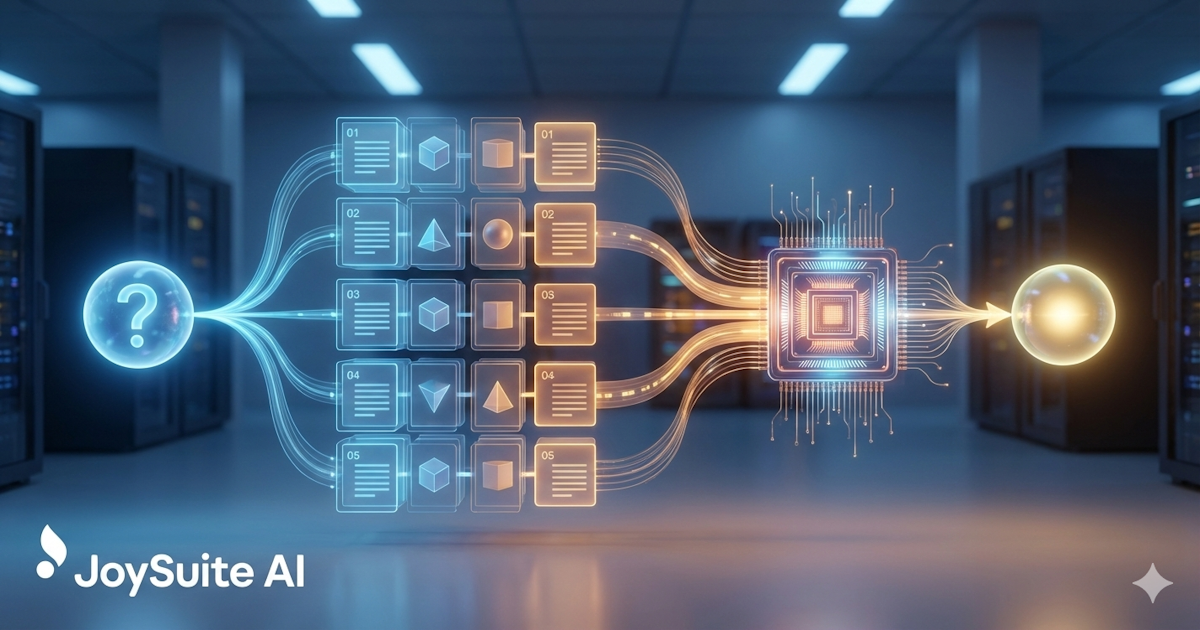

Cómo Funciona RAG: La Versión Simple

Aquí está el proceso de RAG en términos sencillos:

- Almacenas tus documentos. Tus políticas, procedimientos, documentación, lo que sea sobre lo que quieras que la IA responda preguntas, se procesan y almacenan en una base de datos especial.

- Alguien hace una pregunta. "¿Cuál es nuestra política de licencia parental?"

- El sistema encuentra contenido relevante. Busca en tus documentos almacenados las secciones con más probabilidades de contener la respuesta.

- La IA lee y responde. El contenido relevante se entrega a la IA junto con la pregunta. La IA lo lee y genera una respuesta.

- Recibes una respuesta con fuentes. La respuesta incluye de dónde provino la información, para que puedas verificar.

La idea clave: la IA no está tratando de recordar tus políticas del entrenamiento. Las está leyendo ahora mismo, en respuesta a tu pregunta.

Los Componentes Técnicos

Para quienes quieran entender qué está sucediendo bajo el capó, RAG involucra varios componentes técnicos trabajando juntos.

Embeddings: Comprendiendo el Significado

Las computadoras no entienden naturalmente el lenguaje. La palabra "vacaciones" y "licencia" significan cosas similares para los humanos, pero para una computadora, son solo cadenas diferentes de caracteres.

Los embeddings resuelven esto convirtiendo texto en números que capturan el significado. Específicamente, los embeddings convierten texto en listas de números (vectores) donde significados similares producen números similares.

"¿Cuál es nuestra política de licencia?" y "¿Cuántas vacaciones tengo?" tendrían embeddings similares, aunque comparten pocas palabras. Así es como el sistema entiende que están preguntando lo mismo.

Ejemplo: "Rey" y "Reina" tendrían embeddings similares: ambos son realeza. "Rey" y "Teclado" tendrían embeddings muy diferentes a pesar de que ambos empiezan con vocales.

Bases de Datos Vectoriales: Encontrando Contenido Similar

Una vez que has convertido tus documentos en embeddings, necesitas almacenarlos y buscarlos eficientemente. Eso es lo que hacen las bases de datos vectoriales.

Cuando alguien hace una pregunta, tú:

- Conviertes la pregunta en un embedding

- Buscas en la base de datos vectorial embeddings de documentos que sean similares

- Devuelves los fragmentos de documentos más similares

Esto es "búsqueda semántica": encontrar contenido por significado en lugar de solo coincidencia de palabras clave. Por eso "¿Cómo solicito tiempo libre?" puede encontrar un documento titulado "Procedimiento de Solicitud de Licencia".

Chunking: Dividiendo Documentos

Los LLM solo pueden procesar cierta cantidad de texto a la vez (su "ventana de contexto"). Un manual de políticas de 100 páginas no cabrá. Así que los documentos se dividen en fragmentos más pequeños, tal vez de 500-1000 palabras cada uno.

Cuando buscas, estás encontrando los fragmentos más relevantes, no documentos completos. Esto en realidad es una ventaja: le das a la IA exactamente la sección relevante en lugar de hacerla procesar páginas de contenido irrelevante.

Cómo divides los documentos importa. Demasiado pequeños, y los fragmentos carecen de contexto. Demasiado grandes, y diluyes la información relevante con texto irrelevante. El arte del chunking es encontrar la granularidad correcta para tu contenido.

Modelos de Lenguaje Grandes: Generando Respuestas

Una vez que has recuperado el contenido relevante, un LLM genera la respuesta. El LLM recibe:

- La pregunta del usuario

- El contenido recuperado (el "contexto")

- Instrucciones sobre cómo responder (el "prompt del sistema")

Un prompt típico podría decir: "Responde la pregunta del usuario basándote solo en el contexto proporcionado. Si el contexto no contiene suficiente información para responder, dilo. Cita tus fuentes".

El LLM entonces genera una respuesta basada en esta combinación: una respuesta en lenguaje natural extraída de tu contenido específico.

Por Qué RAG Supera Otros Enfoques

vs. LLM Puros

Usar un LLM sin RAG significa depender de los datos de entrenamiento del modelo. Para conocimiento organizacional, esto significa alucinación: el modelo inventará respuestas que suenan plausibles pero son incorrectas.

RAG fundamenta el modelo en tu contenido real. El riesgo de alucinación se reduce (aunque no se elimina) porque el modelo tiene material fuente real con el que trabajar.

vs. Fine-tuning

El fine-tuning entrena el modelo con tu contenido. Esto puede funcionar pero tiene desventajas significativas:

- Costoso y consume mucho tiempo

- Debe rehacerse cuando el contenido cambia

- No escala bien a colecciones grandes de documentos

- Puede degradar el rendimiento en otras tareas

RAG es más práctico para la mayoría de los casos de uso de gestión del conocimiento. El contenido puede cambiar y el sistema se adapta inmediatamente.

vs. Búsqueda Tradicional

La búsqueda tradicional devuelve documentos. RAG devuelve respuestas. La experiencia del usuario es dramáticamente mejor: en lugar de escanear resultados de búsqueda y leer documentos, los usuarios obtienen respuestas directas a sus preguntas.

Qué Hace que RAG Sea Bueno o Malo

No todas las implementaciones de RAG son iguales. La calidad depende de varios factores:

Calidad de Recuperación

La IA solo puede responder bien si encuentra el contenido correcto. Una recuperación deficiente (perder documentos relevantes o incluir irrelevantes) conduce a respuestas deficientes.

La calidad de recuperación depende de:

- Calidad del modelo de embedding

- Estrategia de chunking

- Sofisticación del algoritmo de búsqueda

- Cobertura y organización del contenido

El mejor LLM del mundo no puede responder con contenido que no se le dio. La recuperación es el fundamento: si es débil, todo lo que se construye sobre ella sufre.

Calidad del Contenido

RAG solo puede responder a partir de lo que está en tu base de conocimiento. Si tus políticas están desactualizadas, la IA proporcionará información desactualizada, con confianza. Si tienes documentos contradictorios, la IA puede citar el incorrecto.

Este es el requisito que a menudo se pasa por alto: RAG hace que la calidad de tu contenido sea más importante, no menos. La IA amplifica lo que sea que tengas, bueno o malo.

Ingeniería de Prompts

Cómo instruyes al LLM importa. Los buenos prompts ayudan al modelo a:

- Mantenerse fundamentado en el contexto proporcionado

- Reconocer cuando no tiene suficiente información

- Formatear respuestas claramente

- Citar fuentes apropiadamente

Los prompts deficientes conducen a alucinación, respuestas poco útiles o falta de uso efectivo del contexto recuperado.

Estrategia de Chunking

Cómo se dividen los documentos en fragmentos afecta qué se recupera y qué tan útil es. El mismo documento puede tener un rendimiento muy diferente dependiendo de cómo se fragmente.

RAG en la Práctica

Aquí está cómo se ve realmente una interacción impulsada por RAG:

Usuario pregunta: "¿Cuál es el proceso para solicitar una licencia por ausencia?"

Sistema encuentra: Tres fragmentos relevantes de tus documentos de política de RH y manual del empleado.

Sistema envía al LLM: La pregunta más esos tres fragmentos más instrucciones para responder basándose en el contenido.

LLM genera: "Para solicitar una licencia por ausencia, envía una solicitud a través del portal de RH con al menos 30 días de anticipación. Necesitarás especificar las fechas, motivo de la licencia y si solicitas licencia pagada o no pagada. Tu gerente y RH revisarán y responderán dentro de 5 días hábiles. Para licencias médicas, puede requerirse documentación adicional de un proveedor de atención médica".

Usuario recibe: La respuesta más citas que muestran de qué documentos provino la información.

Todo el proceso toma segundos. El usuario no necesitó buscar en múltiples documentos ni saber qué terminología usar.

Limitaciones de RAG

RAG no es perfecto. Entender sus limitaciones ayuda a establecer expectativas realistas.

El Riesgo de Alucinación Permanece

RAG reduce la alucinación pero no la elimina. El LLM aún puede malinterpretar contenido, hacer inferencias incorrectas u ocasionalmente generar información que no está en el contexto.

Por eso las citas importan: los usuarios pueden verificar las afirmaciones contra los documentos fuente.

Fallos de Recuperación

A veces el contenido correcto existe pero no se recupera. La pregunta podría usar terminología diferente, o la información relevante podría estar distribuida entre documentos de maneras que dificultan la recuperación.

Límites de Ventana de Contexto

Los LLM solo pueden procesar cierta cantidad de texto. Las preguntas complejas que requieren sintetizar muchos documentos pueden alcanzar límites sobre cuánto contexto se puede proporcionar.

Vacíos de Contenido

RAG no puede responder preguntas sobre cosas que no están documentadas. Si la información no está en tu base de conocimiento, la IA no puede encontrarla.

Importante: Cuando la IA no puede responder, quieres que lo diga claramente en lugar de inventar algo. Las buenas implementaciones de RAG son honestas sobre las limitaciones, pero esto requiere una cuidadosa ingeniería de prompts.

El Futuro de RAG

La tecnología continúa evolucionando rápidamente:

Mejores métodos de recuperación. Los enfoques híbridos que combinan búsqueda semántica y por palabras clave, modelos de reclasificación y técnicas de múltiples consultas están mejorando la calidad de recuperación.

Ventanas de contexto más grandes. Los modelos están manejando más contexto, permitiendo respuestas de más fuentes simultáneamente.

Capacidades multimodales. RAG se está expandiendo más allá del texto para incluir imágenes, diagramas y otros tipos de contenido.

Comportamiento agéntico. Los sistemas RAG están comenzando a tomar acciones, no solo respondiendo preguntas sino realizando tareas basadas en conocimiento recuperado.

Conclusión

RAG es la tecnología que hace práctica la gestión del conocimiento con IA. Al combinar recuperación con generación, permite que la IA responda preguntas a partir de tu contenido específico, no solo conocimiento general.

La idea clave: RAG no hace que la IA sea más inteligente sobre tu organización. Le da a la IA acceso al conocimiento de tu organización en el momento en que necesita responder. La IA lee tu contenido y genera una respuesta a partir de lo que lee.

Esta arquitectura simple tiene implicaciones profundas. El conocimiento que estaba atrapado en documentos se vuelve accesible a través de conversación natural. Las preguntas que requerían buscar, leer y sintetizar pueden responderse instantáneamente.

Entender RAG te ayuda a evaluar herramientas de conocimiento de IA, establecer expectativas realistas e invertir apropiadamente en la calidad del contenido, el fundamento sobre el que se construye RAG.

JoySuite utiliza una arquitectura RAG sofisticada para entregar respuestas instantáneas desde el conocimiento de tu organización. Conecta tus fuentes de contenido y deja que la IA haga el trabajo de encontrar y sintetizar información, para que tu equipo pueda enfocarse en el trabajo que realmente importa.