Punti Chiave

- Il RAG (Retrieval-Augmented Generation) combina il recupero di informazioni rilevanti con la generazione di risposte—è il modo in cui gli assistenti AI rispondono alle domande sui tuoi documenti specifici.

- A differenza di ChatGPT da solo, i sistemi basati su RAG sono radicati nei tuoi contenuti, riducendo le allucinazioni e consentendo risposte accurate sulla tua organizzazione.

- I componenti chiave sono gli embedding (comprensione del significato), i database vettoriali (ricerca di contenuti simili) e gli LLM (generazione di risposte dal contesto).

- La qualità del RAG dipende dalla qualità del recupero—l'AI può rispondere bene solo se trova prima i contenuti giusti.

Quando fai una domanda a ChatGPT, risponde da ciò che ha appreso durante l'addestramento—testi di internet di anni fa. Non conosce le policy della tua azienda, la documentazione dei tuoi prodotti o l'annuncio della scorsa settimana.

Va bene per le conoscenze generali. È inutile per le conoscenze organizzative.

Il RAG—Retrieval-Augmented Generation—risolve questo problema. È la tecnologia che alimenta gli assistenti di conoscenza AI, consentendo all'AI di rispondere alle domande sui tuoi contenuti specifici piuttosto che solo sulle conoscenze generali.

Questo articolo spiega come funziona il RAG. Non è necessario essere tecnici per seguire—copriremo i concetti in termini pratici, poi approfondiremo per chi vuole maggiori dettagli.

Il Problema che il RAG Risolve

I large language model (LLM) come GPT-4 o Claude sono addestrati su quantità massive di testo. Sono straordinariamente bravi a comprendere e generare linguaggio umano. Ma hanno una limitazione fondamentale: sanno solo ciò su cui sono stati addestrati.

La tua policy sulle ferie? Non nei dati di addestramento. Le specifiche dei tuoi prodotti? Non ci sono. Le tue procedure interne? Assolutamente no.

Hai due opzioni:

Opzione 1: Fine-tuning. Addestrare il modello sui tuoi contenuti così che "impari" le tue informazioni. Questo è costoso, lento e problematico per contenuti che cambiano. Ogni volta che aggiorni una policy, dovresti riaddestare il modello.

Opzione 2: Retrieval-Augmented Generation. Invece di addestrare il modello sui tuoi contenuti, glieli fornisci al momento della query. Quando qualcuno fa una domanda, trovi i documenti rilevanti e li consegni all'AI insieme alla domanda. L'AI genera una risposta basata su ciò che le hai appena fornito.

Il RAG è l'Opzione 2. È più veloce, più economico e funziona con contenuti che cambiano.

Analogia: Il fine-tuning è come memorizzare un libro di testo. Il RAG è come sostenere un esame a libro aperto. Il modello non ha bisogno di "conoscere" i tuoi contenuti—deve solo essere in grado di leggerli quando gli viene posta una domanda.

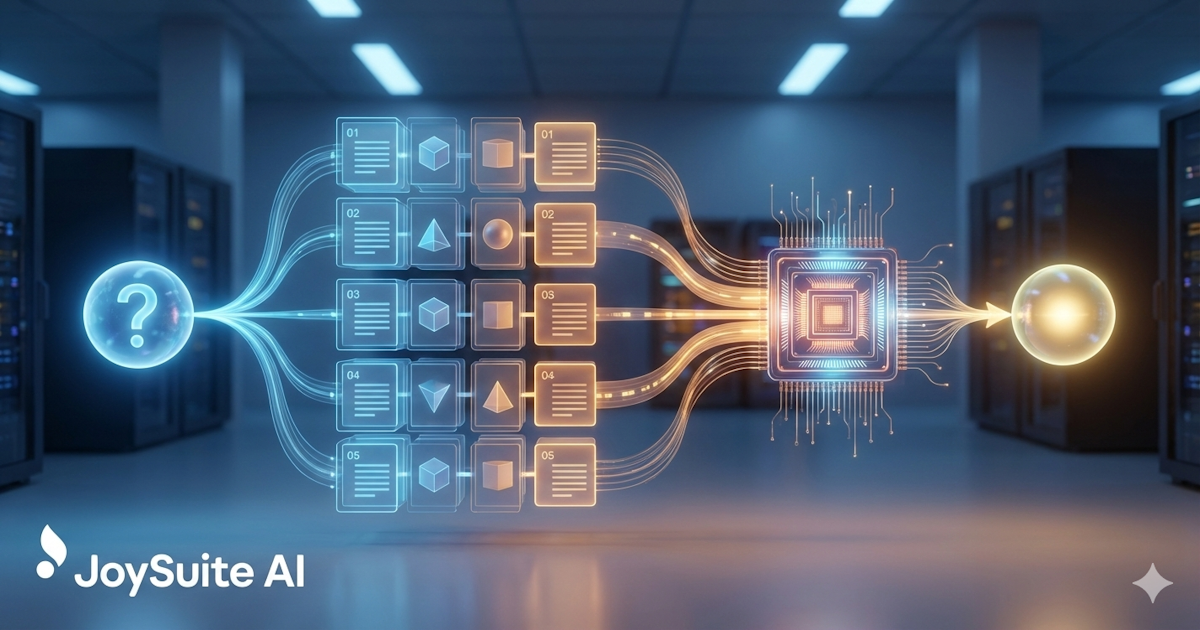

Come Funziona il RAG: La Versione Semplice

Ecco il processo RAG in termini semplici:

- Memorizzi i tuoi documenti. Le tue policy, procedure, documentazione—tutto ciò su cui vuoi che l'AI risponda alle domande—vengono elaborati e memorizzati in un database speciale.

- Qualcuno fa una domanda. "Qual è la nostra policy sul congedo parentale?"

- Il sistema trova i contenuti rilevanti. Cerca nei tuoi documenti memorizzati le sezioni che hanno più probabilità di contenere la risposta.

- L'AI legge e risponde. I contenuti rilevanti vengono forniti all'AI insieme alla domanda. L'AI li legge e genera una risposta.

- Ricevi una risposta con le fonti. La risposta include da dove provengono le informazioni, così puoi verificare.

L'intuizione chiave: l'AI non sta cercando di ricordare le tue policy dall'addestramento. Le sta leggendo proprio ora, in risposta alla tua domanda.

I Componenti Tecnici

Per chi vuole capire cosa succede dietro le quinte, il RAG coinvolge diversi componenti tecnici che lavorano insieme.

Embedding: Comprendere il Significato

I computer non comprendono naturalmente il linguaggio. Le parole "vacanza" e "ferie" significano cose simili per gli umani, ma per un computer sono solo stringhe di caratteri diverse.

Gli embedding risolvono questo convertendo il testo in numeri che catturano il significato. Nello specifico, gli embedding convertono il testo in liste di numeri (vettori) dove significati simili producono numeri simili.

"Qual è la nostra policy sulle ferie?" e "Quanto tempo di vacanza ho?" avrebbero embedding simili, anche se condividono poche parole. È così che il sistema comprende che stanno chiedendo la stessa cosa.

Esempio: "Re" e "Regina" avrebbero embedding simili—sono entrambi nobiltà. "Re" e "Tastiera" avrebbero embedding molto diversi nonostante entrambi inizino con la stessa lettera.

Database Vettoriali: Trovare Contenuti Simili

Una volta convertiti i tuoi documenti in embedding, devi memorizzarli e cercarli in modo efficiente. È ciò che fanno i database vettoriali.

Quando qualcuno fa una domanda, tu:

- Converti la domanda in un embedding

- Cerchi nel database vettoriale gli embedding dei documenti che sono simili

- Restituisci i frammenti di documento più simili

Questa è la "ricerca semantica"—trovare contenuti per significato piuttosto che solo per corrispondenza di parole chiave. È per questo che "Come faccio a richiedere un permesso?" può trovare un documento intitolato "Procedura di Richiesta Ferie."

Chunking: Suddividere i Documenti

Gli LLM possono elaborare solo una certa quantità di testo alla volta (la loro "finestra di contesto"). Un manuale di policy di 100 pagine non ci starà. Quindi i documenti vengono suddivisi in frammenti più piccoli—forse 500-1000 parole ciascuno.

Quando cerchi, stai trovando i frammenti più rilevanti, non interi documenti. Questo è in realtà un vantaggio: dai all'AI esattamente la sezione rilevante piuttosto che farle elaborare pagine di contenuto irrilevante.

Il modo in cui suddividi i documenti è importante. Troppo piccoli, e i frammenti mancano di contesto. Troppo grandi, e diluisci le informazioni rilevanti con testo irrilevante. L'arte del chunking è trovare la giusta granularità per i tuoi contenuti.

Large Language Model: Generare Risposte

Una volta recuperati i contenuti rilevanti, un LLM genera la risposta. L'LLM riceve:

- La domanda dell'utente

- I contenuti recuperati (il "contesto")

- Istruzioni su come rispondere (il "prompt di sistema")

Un prompt tipico potrebbe dire: "Rispondi alla domanda dell'utente basandoti solo sul contesto fornito. Se il contesto non contiene informazioni sufficienti per rispondere, dillo. Cita le tue fonti."

L'LLM genera quindi una risposta basata su questa combinazione—una risposta in linguaggio naturale tratta dai tuoi contenuti specifici.

Perché il RAG Batte Altri Approcci

vs. LLM Base

Usare un LLM senza RAG significa affidarsi ai dati di addestramento del modello. Per le conoscenze organizzative, questo significa allucinazione—il modello inventerà risposte che suonano plausibili ma sono errate.

Il RAG radica il modello nei tuoi contenuti effettivi. Il rischio di allucinazione è ridotto (anche se non eliminato) perché il modello ha materiale sorgente reale su cui lavorare.

vs. Fine-tuning

Il fine-tuning addestra il modello sui tuoi contenuti. Questo può funzionare ma ha svantaggi significativi:

- Costoso e richiede tempo

- Deve essere rifatto quando i contenuti cambiano

- Non scala bene a grandi collezioni di documenti

- Può degradare le prestazioni su altri compiti

Il RAG è più pratico per la maggior parte dei casi d'uso di gestione della conoscenza. I contenuti possono cambiare, e il sistema si adatta immediatamente.

vs. Ricerca Tradizionale

La ricerca tradizionale restituisce documenti. Il RAG restituisce risposte. L'esperienza utente è drammaticamente migliore—invece di scorrere i risultati di ricerca e leggere documenti, gli utenti ottengono risposte dirette alle loro domande.

Cosa Rende il RAG Buono o Cattivo

Non tutte le implementazioni RAG sono uguali. La qualità dipende da diversi fattori:

Qualità del Recupero

L'AI può rispondere bene solo se trova i contenuti giusti. Un recupero scarso—perdere documenti rilevanti o includere quelli irrilevanti—porta a risposte scarse.

La qualità del recupero dipende da:

- Qualità del modello di embedding

- Strategia di chunking

- Sofisticazione dell'algoritmo di ricerca

- Copertura e organizzazione dei contenuti

Il miglior LLM al mondo non può rispondere da contenuti che non gli sono stati forniti. Il recupero è il fondamento—se è debole, tutto ciò che viene costruito su di esso soffre.

Qualità dei Contenuti

Il RAG può rispondere solo da ciò che è nella tua base di conoscenza. Se le tue policy sono obsolete, l'AI fornirà informazioni obsolete—con sicurezza. Se hai documenti contraddittori, l'AI potrebbe citare quello sbagliato.

Questo è il requisito spesso trascurato: il RAG rende la qualità dei tuoi contenuti più importante, non meno. L'AI amplifica ciò che hai—buono o cattivo.

Ingegneria dei Prompt

Il modo in cui istruisci l'LLM è importante. Buoni prompt aiutano il modello a:

- Rimanere radicato nel contesto fornito

- Riconoscere quando non ha informazioni sufficienti

- Formattare le risposte chiaramente

- Citare le fonti correttamente

Prompt scadenti portano ad allucinazione, risposte poco utili o incapacità di usare efficacemente il contesto recuperato.

Strategia di Chunking

Il modo in cui i documenti vengono suddivisi in frammenti influisce su ciò che viene recuperato e quanto è utile. Lo stesso documento può performare in modo molto diverso a seconda di come viene suddiviso.

Il RAG nella Pratica

Ecco come appare effettivamente un'interazione basata su RAG:

L'utente chiede: "Qual è la procedura per richiedere un congedo?"

Il sistema trova: Tre frammenti rilevanti dai tuoi documenti di policy HR e manuale dei dipendenti.

Il sistema invia all'LLM: La domanda più quei tre frammenti più le istruzioni per rispondere basandosi sui contenuti.

L'LLM genera: "Per richiedere un congedo, invia una richiesta attraverso il portale HR almeno 30 giorni in anticipo. Dovrai specificare le date, il motivo del congedo e se stai richiedendo un congedo retribuito o non retribuito. Il tuo manager e l'HR esamineranno e risponderanno entro 5 giorni lavorativi. Per congedi medici, potrebbe essere richiesta documentazione aggiuntiva da un operatore sanitario."

L'utente riceve: La risposta più le citazioni che mostrano da quali documenti provengono le informazioni.

L'intero processo richiede secondi. L'utente non ha dovuto cercare in più documenti o sapere quale terminologia usare.

Limitazioni del RAG

Il RAG non è perfetto. Comprendere le sue limitazioni aiuta a stabilire aspettative realistiche.

Il Rischio di Allucinazione Rimane

Il RAG riduce l'allucinazione ma non la elimina. L'LLM può ancora interpretare male i contenuti, fare inferenze errate o occasionalmente generare informazioni non presenti nel contesto.

Ecco perché le citazioni sono importanti—gli utenti possono verificare le affermazioni confrontandole con i documenti sorgente.

Mancati Recuperi

A volte i contenuti giusti esistono ma non vengono recuperati. La domanda potrebbe usare una terminologia diversa, o le informazioni rilevanti potrebbero essere distribuite tra documenti in modi che rendono difficile il recupero.

Limiti della Finestra di Contesto

Gli LLM possono elaborare solo una certa quantità di testo. Domande complesse che richiedono la sintesi di molti documenti potrebbero raggiungere i limiti di quanto contesto può essere fornito.

Lacune nei Contenuti

Il RAG non può rispondere a domande su cose che non sono documentate. Se l'informazione non è nella tua base di conoscenza, l'AI non può trovarla.

Importante: Quando l'AI non può rispondere, vuoi che lo dica chiaramente piuttosto che inventare qualcosa. Buone implementazioni RAG sono oneste sui loro limiti—ma questo richiede un'attenta ingegneria dei prompt.

Il Futuro del RAG

La tecnologia continua a evolversi rapidamente:

Metodi di recupero migliori. Approcci ibridi che combinano ricerca semantica e per parole chiave, modelli di re-ranking e tecniche multi-query stanno migliorando la qualità del recupero.

Finestre di contesto più ampie. I modelli stanno gestendo più contesto, consentendo risposte da più fonti simultaneamente.

Capacità multimodali. Il RAG si sta espandendo oltre il testo per includere immagini, diagrammi e altri tipi di contenuto.

Comportamento agentivo. I sistemi RAG stanno iniziando a compiere azioni—non solo rispondere a domande ma eseguire compiti basati sulla conoscenza recuperata.

Conclusione

Il RAG è la tecnologia che rende pratica la gestione della conoscenza AI. Combinando recupero e generazione, consente all'AI di rispondere a domande sui tuoi contenuti specifici—non solo conoscenze generali.

L'intuizione chiave: il RAG non rende l'AI più intelligente sulla tua organizzazione. Dà all'AI accesso alla conoscenza della tua organizzazione nel momento in cui deve rispondere. L'AI legge i tuoi contenuti e genera una risposta da ciò che legge.

Questa semplice architettura ha implicazioni profonde. La conoscenza intrappolata nei documenti diventa accessibile attraverso conversazioni naturali. Domande che richiedevano ricerca, lettura e sintesi possono ricevere risposta istantaneamente.

Comprendere il RAG ti aiuta a valutare gli strumenti di conoscenza AI, stabilire aspettative realistiche e investire in modo appropriato nella qualità dei contenuti—il fondamento su cui il RAG si costruisce.

JoySuite utilizza un'architettura RAG sofisticata per fornire risposte istantanee dalla tua conoscenza organizzativa. Connetti le tue fonti di contenuto, e lascia che l'AI faccia il lavoro di trovare e sintetizzare le informazioni—così il tuo team può concentrarsi sul lavoro che conta davvero.