Wichtige Erkenntnisse

- RAG (Retrieval-Augmented Generation) kombiniert das Finden relevanter Informationen mit der Generierung von Antworten – so können KI-Assistenten Fragen aus Ihren spezifischen Dokumenten beantworten.

- Im Gegensatz zu ChatGPT allein sind RAG-gestützte Systeme in Ihren Inhalten verankert, reduzieren Halluzinationen und ermöglichen präzise Antworten über Ihre Organisation.

- Die Schlüsselkomponenten sind Embeddings (Bedeutung verstehen), Vektordatenbanken (ähnliche Inhalte finden) und LLMs (Antworten aus dem Kontext generieren).

- Die RAG-Qualität hängt von der Abrufqualität ab – die KI kann nur dann gut antworten, wenn sie zuerst die richtigen Inhalte findet.

Wenn Sie ChatGPT eine Frage stellen, antwortet es aus dem, was es während des Trainings gelernt hat – Internettexte von vor Jahren. Es kennt weder die Richtlinien Ihres Unternehmens noch Ihre Produktdokumentation oder die Ankündigung von letzter Woche.

Das ist für allgemeines Wissen in Ordnung. Für organisatorisches Wissen ist es nutzlos.

RAG – Retrieval-Augmented Generation – löst dieses Problem. Es ist die Technologie, die KI-Wissensassistenten antreibt und es der KI ermöglicht, Fragen aus Ihren spezifischen Inhalten zu beantworten statt nur aus allgemeinem Wissen.

Dieser Artikel erklärt, wie RAG funktioniert. Sie müssen nicht technisch versiert sein, um folgen zu können – wir behandeln die Konzepte in praktischen Begriffen und gehen dann für diejenigen, die mehr Details wünschen, tiefer ins Detail.

Das Problem, das RAG löst

Große Sprachmodelle (LLMs) wie GPT-4 oder Claude werden mit enormen Textmengen trainiert. Sie sind bemerkenswert gut darin, menschliche Sprache zu verstehen und zu generieren. Aber sie haben eine fundamentale Einschränkung: Sie kennen nur das, womit sie trainiert wurden.

Ihre Urlaubsrichtlinie? Nicht in den Trainingsdaten. Ihre Produktspezifikationen? Auch nicht dort. Ihre internen Verfahren? Definitiv nicht.

Sie haben zwei Optionen:

Option 1: Fine-Tuning. Trainieren Sie das Modell mit Ihren Inhalten, damit es Ihre Informationen «lernt». Das ist teuer, langsam und problematisch für sich ändernde Inhalte. Jedes Mal, wenn Sie eine Richtlinie aktualisieren, müssten Sie das Modell neu trainieren.

Option 2: Retrieval-Augmented Generation. Anstatt das Modell mit Ihren Inhalten zu trainieren, geben Sie ihm Ihre Inhalte zur Abfragezeit. Wenn jemand eine Frage stellt, finden Sie die relevanten Dokumente und übergeben sie zusammen mit der Frage an die KI. Die KI generiert eine Antwort basierend auf dem, was Sie ihr gerade gegeben haben.

RAG ist Option 2. Es ist schneller, günstiger und funktioniert mit sich ändernden Inhalten.

Analogie: Fine-Tuning ist wie ein Lehrbuch auswendig zu lernen. RAG ist wie eine Prüfung mit offenen Büchern zu machen. Das Modell muss Ihre Inhalte nicht «kennen» – es muss sie nur lesen können, wenn eine Frage gestellt wird.

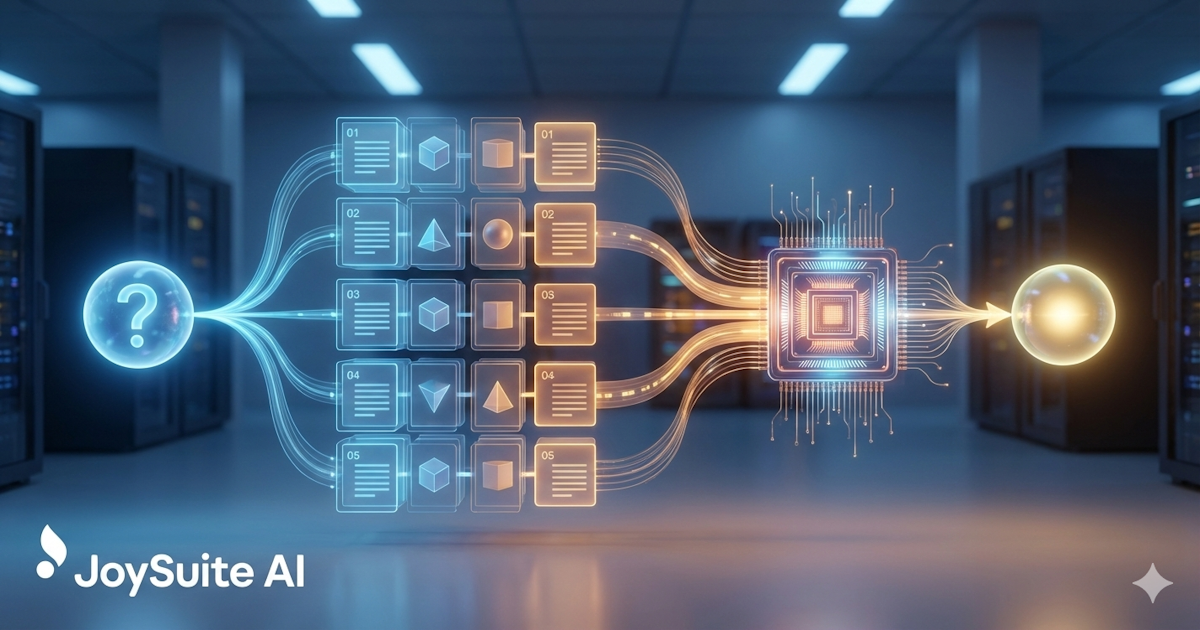

Wie RAG funktioniert: Die einfache Version

Hier ist der RAG-Prozess in einfachen Worten:

- Sie speichern Ihre Dokumente. Ihre Richtlinien, Verfahren, Dokumentationen – alles, wozu die KI Fragen beantworten soll – werden verarbeitet und in einer speziellen Datenbank gespeichert.

- Jemand stellt eine Frage. «Was ist unsere Elternzeitregelung?»

- Das System findet relevante Inhalte. Es durchsucht Ihre gespeicherten Dokumente nach Abschnitten, die am wahrscheinlichsten die Antwort enthalten.

- Die KI liest und antwortet. Die relevanten Inhalte werden zusammen mit der Frage an die KI übergeben. Die KI liest sie und generiert eine Antwort.

- Sie erhalten eine Antwort mit Quellen. Die Antwort enthält Angaben, woher die Informationen stammen, sodass Sie sie überprüfen können.

Die zentrale Erkenntnis: Die KI versucht nicht, sich Ihre Richtlinien aus dem Training zu merken. Sie liest sie gerade jetzt, als Reaktion auf Ihre Frage.

Die technischen Komponenten

Für diejenigen, die verstehen möchten, was unter der Haube passiert, umfasst RAG mehrere technische Komponenten, die zusammenarbeiten.

Embeddings: Bedeutung verstehen

Computer verstehen Sprache nicht auf natürliche Weise. Die Wörter «Urlaub» und «Freistellung» bedeuten für Menschen Ähnliches, aber für einen Computer sind sie nur unterschiedliche Zeichenketten.

Embeddings lösen dies, indem sie Text in Zahlen umwandeln, die Bedeutung erfassen. Konkret wandeln Embeddings Text in Zahlenlisten (Vektoren) um, bei denen ähnliche Bedeutungen ähnliche Zahlen erzeugen.

«Was ist unsere Freistellungsregelung?» und «Wie viel Urlaub bekomme ich?» hätten ähnliche Embeddings, obwohl sie wenige Wörter gemeinsam haben. So versteht das System, dass sie dieselbe Sache fragen.

Beispiel: «König» und «Königin» hätten ähnliche Embeddings – beide sind Königsgeschlecht. «König» und «Tastatur» hätten sehr unterschiedliche Embeddings, obwohl beide mit 'K' beginnen.

Vektordatenbanken: Ähnliche Inhalte finden

Sobald Sie Ihre Dokumente in Embeddings umgewandelt haben, müssen Sie sie speichern und effizient durchsuchen. Das tun Vektordatenbanken.

Wenn jemand eine Frage stellt:

- Wandeln Sie die Frage in ein Embedding um

- Durchsuchen Sie die Vektordatenbank nach ähnlichen Dokument-Embeddings

- Geben Sie die ähnlichsten Dokumentteile zurück

Das ist «semantische Suche» – Inhalte nach Bedeutung finden statt nur nach Schlüsselwörtern. Deshalb kann «Wie beantrage ich Freizeit?» ein Dokument mit dem Titel «Verfahren zur Freistellungsanfrage» finden.

Chunking: Dokumente aufteilen

LLMs können nur eine begrenzte Textmenge auf einmal verarbeiten (ihr «Kontextfenster»). Ein 100-seitiges Richtlinienhandbuch passt nicht hinein. Deshalb werden Dokumente in kleinere Teile aufgeteilt – vielleicht 500-1000 Wörter pro Teil.

Wenn Sie suchen, finden Sie die relevantesten Teile, nicht ganze Dokumente. Das ist tatsächlich ein Vorteil: Sie geben der KI genau den relevanten Abschnitt, anstatt sie Seiten irrelevanter Inhalte verarbeiten zu lassen.

Wie Sie Dokumente aufteilen, ist wichtig. Zu klein, und den Teilen fehlt Kontext. Zu groß, und Sie verwässern relevante Informationen mit irrelevantem Text. Die Kunst des Chunkings besteht darin, die richtige Granularität für Ihre Inhalte zu finden.

Large Language Models: Antworten generieren

Sobald Sie relevante Inhalte abgerufen haben, generiert ein LLM die Antwort. Das LLM erhält:

- Die Frage des Benutzers

- Die abgerufenen Inhalte (den «Kontext»)

- Anweisungen, wie zu antworten ist (der «System-Prompt»)

Ein typischer Prompt könnte lauten: «Beantworten Sie die Frage des Benutzers nur basierend auf dem bereitgestellten Kontext. Wenn der Kontext nicht genug Informationen zur Beantwortung enthält, sagen Sie das. Zitieren Sie Ihre Quellen.»

Das LLM generiert dann eine Antwort basierend auf dieser Kombination – eine natürlichsprachige Antwort, die aus Ihren spezifischen Inhalten gezogen wird.

Warum RAG andere Ansätze schlägt

vs. reine LLMs

Ein LLM ohne RAG zu verwenden bedeutet, sich auf die Trainingsdaten des Modells zu verlassen. Für organisatorisches Wissen bedeutet das Halluzination – das Modell wird plausibel klingende, aber falsche Antworten erfinden.

RAG verankert das Modell in Ihren tatsächlichen Inhalten. Das Halluzinationsrisiko wird reduziert (wenn auch nicht eliminiert), weil das Modell echtes Quellmaterial zur Verfügung hat.

vs. Fine-Tuning

Fine-Tuning trainiert das Modell mit Ihren Inhalten. Das kann funktionieren, hat aber erhebliche Nachteile:

- Teuer und zeitaufwändig

- Muss wiederholt werden, wenn sich Inhalte ändern

- Skaliert nicht gut für große Dokumentsammlungen

- Kann die Leistung bei anderen Aufgaben beeinträchtigen

RAG ist für die meisten Wissensmanagement-Anwendungsfälle praktischer. Inhalte können sich ändern, und das System passt sich sofort an.

vs. traditionelle Suche

Traditionelle Suche liefert Dokumente. RAG liefert Antworten. Die Benutzererfahrung ist dramatisch besser – anstatt Suchergebnisse zu scannen und Dokumente zu lesen, erhalten Benutzer direkte Antworten auf ihre Fragen.

Was RAG gut oder schlecht macht

Nicht alle RAG-Implementierungen sind gleich. Die Qualität hängt von mehreren Faktoren ab:

Abrufqualität

Die KI kann nur dann gut antworten, wenn sie die richtigen Inhalte findet. Schlechter Abruf – relevante Dokumente werden übersehen oder irrelevante einbezogen – führt zu schlechten Antworten.

Die Abrufqualität hängt ab von:

- Qualität des Embedding-Modells

- Chunking-Strategie

- Raffinesse des Suchalgorithmus

- Inhaltsabdeckung und -organisation

Das beste LLM der Welt kann nicht aus Inhalten antworten, die ihm nicht gegeben wurden. Der Abruf ist das Fundament – wenn er schwach ist, leidet alles, was darauf aufbaut.

Inhaltsqualität

RAG kann nur aus dem antworten, was in Ihrer Wissensdatenbank ist. Wenn Ihre Richtlinien veraltet sind, wird die KI veraltete Informationen liefern – selbstsicher. Wenn Sie widersprüchliche Dokumente haben, könnte die KI das falsche zitieren.

Das ist die oft übersehene Anforderung: RAG macht Ihre Inhaltsqualität wichtiger, nicht weniger wichtig. Die KI verstärkt, was auch immer Sie haben – gut oder schlecht.

Prompt Engineering

Wie Sie das LLM anweisen, ist wichtig. Gute Prompts helfen dem Modell:

- Im bereitgestellten Kontext verankert zu bleiben

- Anzuerkennen, wenn es nicht genug Informationen hat

- Antworten klar zu formatieren

- Quellen ordnungsgemäß zu zitieren

Schlechte Prompts führen zu Halluzination, wenig hilfreichen Antworten oder Versagen, den abgerufenen Kontext effektiv zu nutzen.

Chunking-Strategie

Wie Dokumente in Teile aufgeteilt werden, beeinflusst, was abgerufen wird und wie nützlich es ist. Dasselbe Dokument kann je nach Aufteilung sehr unterschiedlich abschneiden.

RAG in der Praxis

So sieht eine RAG-gestützte Interaktion tatsächlich aus:

Benutzer fragt: «Was ist das Verfahren zur Beantragung einer Beurlaubung?»

System findet: Drei relevante Teile aus Ihren Personalrichtlinien und dem Mitarbeiterhandbuch.

System sendet an LLM: Die Frage plus diese drei Teile plus Anweisungen, basierend auf dem Inhalt zu antworten.

LLM generiert: «Um eine Beurlaubung zu beantragen, reichen Sie mindestens 30 Tage im Voraus einen Antrag über das Personalportal ein. Sie müssen die Daten, den Grund für die Beurlaubung und angeben, ob Sie bezahlte oder unbezahlte Freistellung beantragen. Ihr Vorgesetzter und die Personalabteilung werden prüfen und innerhalb von 5 Werktagen antworten. Für medizinische Beurlaubungen kann zusätzliche Dokumentation von einem Gesundheitsdienstleister erforderlich sein.»

Benutzer erhält: Die Antwort plus Zitate, die zeigen, aus welchen Dokumenten die Informationen stammen.

Der gesamte Prozess dauert Sekunden. Der Benutzer musste nicht mehrere Dokumente durchsuchen oder wissen, welche Terminologie zu verwenden ist.

Einschränkungen von RAG

RAG ist nicht perfekt. Das Verstehen seiner Einschränkungen hilft, realistische Erwartungen zu setzen.

Halluzinationsrisiko bleibt bestehen

RAG reduziert Halluzination, eliminiert sie aber nicht. Das LLM kann Inhalte immer noch falsch interpretieren, falsche Schlüsse ziehen oder gelegentlich Informationen generieren, die nicht im Kontext sind.

Deshalb sind Zitate wichtig – Benutzer können Behauptungen gegen Quelldokumente überprüfen.

Abrufversäumnisse

Manchmal existieren die richtigen Inhalte, werden aber nicht abgerufen. Die Frage könnte andere Terminologie verwenden, oder die relevanten Informationen könnten über Dokumente verteilt sein auf eine Weise, die den Abruf erschwert.

Kontextfenster-Grenzen

LLMs können nur eine bestimmte Textmenge verarbeiten. Komplexe Fragen, die die Synthese vieler Dokumente erfordern, können an Grenzen stoßen, wie viel Kontext bereitgestellt werden kann.

Inhaltslücken

RAG kann keine Fragen zu Dingen beantworten, die nicht dokumentiert sind. Wenn die Information nicht in Ihrer Wissensdatenbank ist, kann die KI sie nicht finden.

Wichtig: Wenn die KI nicht antworten kann, soll sie das klar sagen, anstatt etwas zu erfinden. Gute RAG-Implementierungen sind ehrlich über Einschränkungen – aber das erfordert sorgfältiges Prompt Engineering.

Die Zukunft von RAG

Die Technologie entwickelt sich weiterhin rasant:

Bessere Abrufmethoden. Hybride Ansätze, die semantische und Schlüsselwortsuche kombinieren, Re-Ranking-Modelle und Multi-Query-Techniken verbessern die Abrufqualität.

Größere Kontextfenster. Modelle verarbeiten mehr Kontext, was Antworten aus mehreren Quellen gleichzeitig ermöglicht.

Multimodale Fähigkeiten. RAG wird über Text hinaus erweitert, um Bilder, Diagramme und andere Inhaltstypen einzubeziehen.

Agentenverhalten. RAG-Systeme beginnen, Aktionen durchzuführen – nicht nur Fragen zu beantworten, sondern Aufgaben basierend auf abgerufenem Wissen auszuführen.

Fazit

RAG ist die Technologie, die KI-Wissensmanagement praktisch macht. Durch die Kombination von Abruf und Generierung ermöglicht es der KI, Fragen aus Ihren spezifischen Inhalten zu beantworten – nicht nur aus allgemeinem Wissen.

Die zentrale Erkenntnis: RAG macht KI nicht intelligenter über Ihre Organisation. Es gibt der KI Zugang zum Wissen Ihrer Organisation in dem Moment, in dem sie antworten muss. Die KI liest Ihre Inhalte und generiert eine Antwort aus dem, was sie liest.

Diese einfache Architektur hat tiefgreifende Auswirkungen. Wissen, das in Dokumenten gefangen war, wird durch natürliche Konversation zugänglich. Fragen, die Suchen, Lesen und Zusammenfassen erforderten, können sofort beantwortet werden.

Das Verstehen von RAG hilft Ihnen, KI-Wissenstools zu bewerten, realistische Erwartungen zu setzen und angemessen in Inhaltsqualität zu investieren – das Fundament, auf dem RAG aufbaut.

JoySuite verwendet eine ausgefeilte RAG-Architektur, um sofortige Antworten aus Ihrem organisatorischen Wissen zu liefern. Verbinden Sie Ihre Inhaltsquellen, und lassen Sie die KI die Arbeit des Findens und Zusammenfassens von Informationen übernehmen – damit sich Ihr Team auf die Arbeit konzentrieren kann, die wirklich wichtig ist.